LLM + Données + Outils : Et si l’IA comprenait enfin votre métier ?

Et si l’IA comprenait enfin votre métier ? Découvrez comment connecter un LLM à vos données, outils et processus grâce au RAG, au Model Context Protocol (MCP) et à une architecture sécurisée, pour créer un véritable assistant métier intelligent.

Introduction : Connecter l’IA à votre entreprise

L’intelligence artificielle générative, incarnée par des modèles de langage comme GPT-4, Mistral, Gemini ou Claude, révolutionne la façon dont les entreprises peuvent innover et gagner en performance. Mais ces modèles, aussi puissants soient-ils, sont limités s’ils ne sont pas connectés à l’environnement spécifique de l’entreprise : ses données, ses outils et ses processus métiers.

Pour exploiter pleinement le potentiel de ces LLM (Large Langage Model), il est essentiel de les intégrer dans un cadre sécurisé, gouverné, et surtout enrichi du contexte métier qui donne à chaque entreprise ses caractéristiques uniques. Dans cet article, nous explorons les leviers technologiques, organisationnels et stratégiques pour réussir l’intégration de l’IA (LLM + données internes + outils du SI), notamment grâce à des protocoles émergents comme le Model Context Protocol (MCP).

1. Pourquoi les LLM seuls ne suffisent pas

Les grands modèles de langage (LLM) comme ChatGPT sont impressionnants par leur capacité à générer du texte, coder ou résumer des documents. Mais ils souffrent d’un défaut majeur : ils ne connaissent pas votre entreprise.

Ils n’ont pas accès à vos données internes, à vos clients, à vos outils métiers ni à votre contexte stratégique. Utilisés tel quel, leur puissance de réponse générique reste le plus souvent peu exploitable dans un cadre opérationnel réel.

Problèmes constatés :

- Réponses génériques sans valeur ajoutée métier

- Manque de cohérence, biais et hallucinations possibles

- Obligation de répéter le contexte à chaque usage

- Risque de fuite de données si mal utilisés via des interfaces publiques

- Réponses limitées à la date à laquelle le modèle a été entrainé

🧱 Exemple concret :

Un responsable RH pose une question à un chatbot IA :

"Quels sont les droits à congé maternité dans notre entreprise pour un contrat en temps partiel ?"

Le LLM répond selon le Code du Travail, sans tenir compte de la convention collective spécifique, ni de l’accord d’entreprise qui accorde 10 jours supplémentaires. Résultat : une réponse inexacte et potentiellement trompeuse, car le modèle est déconnecté de la réalité contractuelle de l’entreprise.

De plus, Les LLM sont entrainés avec des informations collectées jusqu’à une date limite de mise à jour (le “Knowledge cutoff”). Si un nouveau texte de loi avait été adopté après la date de collecte des informations, l’IA n’aurait pas été en mesure de répondre correctement.

Bref, pour qu’un LLM crée de la valeur, il doit être contextualisé, connecté et maîtrisé.

2. Connecter l’IA à vos données : les approches possibles

Pour qu’un modèle de langage devienne véritablement utile dans votre entreprise, il doit pouvoir accéder à vos données spécifiques : documents internes, bases clients, historiques de projets, procédures, etc. Plusieurs technologies permettent cette connexion, chacune jouant un rôle complémentaire.

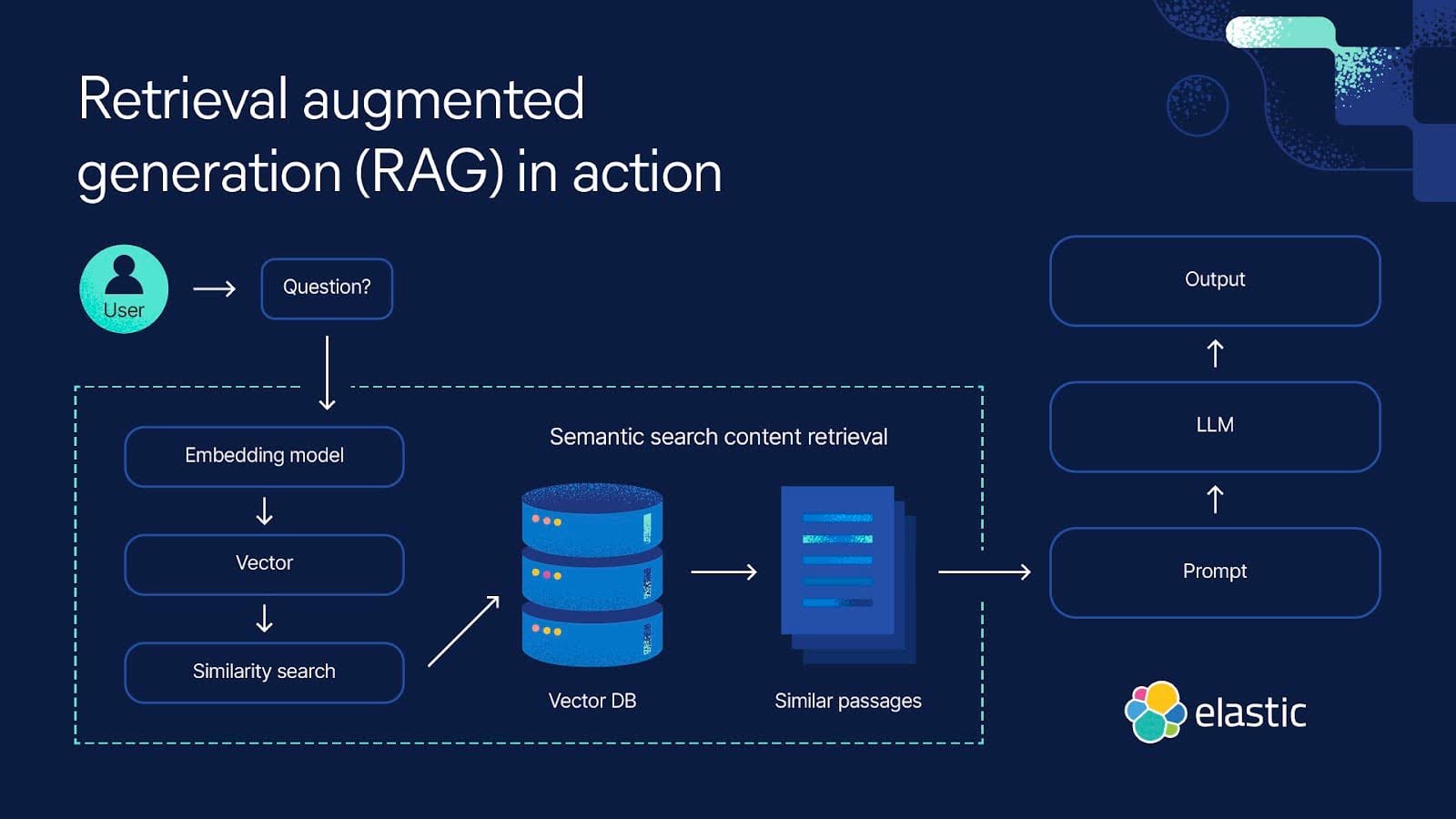

Le RAG (Retrieval-Augmented Generation)

Le RAG consiste à injecter dynamiquement des contenus pertinents dans le prompt du LLM, en les récupérant depuis une base de données ou un corpus documentaire spécifique à l’entreprise. Il agit comme un moteur de recherche qui précède la génération de texte.

Fonctionnement :

- Un vecteur est créé pour chaque document ou extrait (grâce à des embeddings).

- Lorsqu’une requête est formulée, les contenus les plus proches sémantiquement sont récupérés.

- Ces contenus sont ensuite injectés dans le contexte du LLM pour produire une réponse.

Exemples d’usages :

- Chatbot client qui répond en s’appuyant sur votre base de connaissance interne.

- Assistant RH qui génère des réponses à partir du code du travail et de votre convention collective.

- IA juridique qui rédige des contrats en reprenant vos clauses types.

En savoir plus : https://blog.synrune.io/une-memoire-d-entreprise-pour-liberer-le-potentiel-de-l-ia/

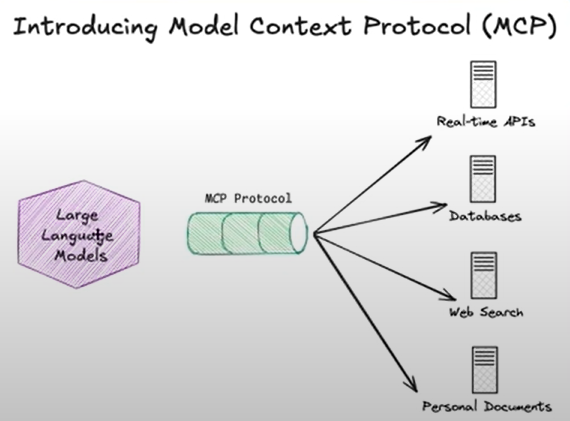

Le rôle clé du Model Context Protocol (MCP)

Le Model Context Protocol (MCP) est une norme émergente permettant d’organiser, structurer et transmettre le contexte utilisateur à un LLM. Il est complémentaire du RAG et agit comme une couche de gouvernance contextuelle.

Ce que MCP apporte :

- Identification de l’utilisateur (son rôle, son service, son historique de requêtes).

- Métadonnées métier (projet en cours, client concerné, échéances, etc.).

- Spécification de la tâche ou du type de réponse attendue (langue, ton, format).

- Chargement automatique de documents ou d’historiques pertinents.

Comment MCP s’articule avec RAG :

- MCP définit le cadre du contexte : qui, quoi, pour quoi faire.

- RAG vient alimenter ce cadre avec des données issues de la mémoire vectorielle ou d’autres sources.

<aside> 📌

Illustration concrète :

Un chef de projet en assurance qualité demande à son copilote IA :

"Prépare une synthèse des non-conformités critiques signalées ce trimestre pour le client X."

- MCP transmet que l’utilisateur est dans l’équipe Qualité, travaille sur le client X, et cherche un rapport synthétique.

- RAG interroge la base documentaire et récupère les rapports d’audit, mails d’alerte, et tickets Jira liés au client X.

- Le LLM rédige une synthèse adaptée au format habituel utilisé dans les comités de pilotage. </aside>

Accès direct aux systèmes internes

Enfin, les LLM peuvent être connectés à des sources dynamiques en temps réel :

- Bases de données (PostgreSQL, MongoDB, BigQuery…)

- APIs d’outils métiers (ERP, CRM, SIRH…)

- Fichiers partagés sur SharePoint, Google Drive ou intranets

Cette approche permet de produire des réponses à jour, enrichies, voire d’exécuter des actions automatisées (ex : créer une fiche client, générer un devis).

En combinant RAG, MCP et connecteurs API, vous pouvez créer une IA véritablement alignée sur la structure, le langage et les enjeux de votre organisation.

3. Connecter l’IA à vos outils : l'autre rôle clef du MCP

Le Model Context Protocol (MCP) ne se limite pas à la gestion de la mémoire ou à la personnalisation des réponses. Il joue un rôle clé pour faciliter l'intégration des LLM avec les outils métiers existants (ERP, CRM, GED, etc.). Il permet aux modèles IA d’interagir de manière fluide et sécurisée avec des outils externes, tout en maintenant une compréhension contextuelle des données, des processus et des utilisateurs.

⚙️ Comment ça fonctionne ?

Un protocole standard et ouvert comme l’USB !

Le Model Context Protocol (MCP) est un protocole ouvert qui propose une façon standardisée de "brancher" l’IA à tout votre environnement, comme un câble USB compatible avec de nombreux accessoires. Comme nous l’avons vu pour connecter les données à l’IA, plutôt que de simplement envoyer un prompt à un LLM (ce qui produirait une réponse générique), le MCP encadre et enrichit cette requête avec des informations contextuelles provenant de l’entreprise.

🚀 Quels sont ses avantages ?

Imaginez que votre modèle d’IA soit un ordinateur, et qu’il ait besoin d’être connecté à vos outils métiers (CRM, ERP…), vos documents ou vos bases de données. Plutôt que de créer une connexion spécifique à chaque outil, le MCP est un protocole ouvert qui propose une façon standardisée de "brancher" l’IA à tout votre environnement, comme un câble unique compatible avec de nombreux accessoires.

Le MCP offre :

- Une liste croissante d'intégrations préconfigurées directement utilisable par le LLM

- La liberté de passer facilement d'un fournisseur de LLM à un autre

- Des bonnes pratiques pour sécuriser vos données au sein de votre infrastructure

🔗 Exemple concret de connexion avec un CRM :

Imaginons qu’un commercial utilise un CRM intégré avec un LLM via le MCP. Plutôt que de poser une question générique à l'IA comme "Quelles sont mes opportunités ?", l’IA va être capable de se rappeler du contexte spécifique du commercial (territoire, type de clients, historique des interactions, etc.). Grâce au MCP, l’IA pourrait répondre avec quelque chose de beaucoup plus utile et personnalisé, comme :

"Voici un résumé des opportunités dans la région Sud, avec les actions suivantes recommandées pour chaque client en fonction de l’historique des dernières interactions."

Le MCP permet ici de fusionner des données internes (CRM) avec des capacités d’analyse du LLM, pour offrir des réponses contextuelles et alignées sur les processus métier.

🛠️ Technologies associées au MCP :

Le MCP fonctionne en harmonie avec d’autres technologies telles que :

- RAG (Retrieval Augmented Generation) : permet à l’IA de consulter en temps réel des bases de données internes (documents, rapports, etc.) avant de générer des réponses précises. Par exemple, en plus d’interroger le CRM, le MCP pourra interroger des bases de connaissances internes (connaissances clients, documents commerciaux, offres actuelles) pour personnaliser la réponse.

- API tierces : pour la connectivité en temps réel aux outils comme Salesforce, HubSpot, ou Microsoft Dynamics. Le MCP permet de structurer les appels aux APIs de manière optimale, en injectant du contexte dans la requête.

- Automatisation des workflows : le MCP facilite l’orchestration des actions entre les outils et l’IA, permettant d’automatiser des processus comme la génération d’offres, l'envoi de rappels ou la gestion de tickets, tout en respectant les règles métier.

💡 Exemple avec Synrune :

Sur une plateforme comme Synrune, qui intègre des modèles IA avec des outils métiers spécifiques, le MCP facilite et organise la connexion fluide entre l'IA et les systèmes de gestion de l'entreprise (par exemple, un ERP pour suivre l'inventaire ou un CRM pour gérer les ventes). Le MCP enrichit ainsi les réponses du LLM avec des données issues directement de ces systèmes, créant une expérience enrichie et hyper-contextualisée pour l’utilisateur.

📌À retenir : le MCP n’est pas simplement un gestionnaire de mémoire, il agit comme un facilitateur d’intégration pour connecter de manière transparente l’IA aux outils métier, tout en enrichissant l'interaction avec les données contextuelles nécessaires à une prise de décision éclairée.

4. Assurer la sécurité, la gouvernance et la conformité : un pilier central de l’IA d’entreprise

Quand une IA est connectée à vos données internes ou à vos outils métier, la puissance de cette technologie doit impérativement s’accompagner d’un cadre de sécurité et de gouvernance solide. Sans cela, les risques dépassent largement les gains.

Quelques grands principes à respecter :

a. Confidentialité et souveraineté des données

Un déploiement IA efficace doit garantir que les données sensibles restent sous contrôle. Cela implique :

- De ne pas exposer de données à des serveurs tiers sans consentement clair

- De privilégier des modèles hébergés localement ou sur des clouds souverains (OpenAI via Azure France, Mistral on-premise, etc.)

- De mettre en place le chiffrement des échanges, y compris lors du passage par les connecteurs API

- D’effacer les fichiers temporaires utilisés dans un RAG après usage

- D'anonymiser les données lorsque cela est possible avant un traitement

📌 Exemple de risque : Un assistant juridique interroge un modèle hébergé sur des serveurs US via une API non sécurisée. Il transmet par erreur une clause contractuelle confidentielle. Résultat : risque de non-conformité RGPD, perte de données sensibles, voire incident juridique.

b. Gouvernance des accès : qui a le droit de faire quoi ?

Une IA connectée ne doit pas être ouverte à tous sans discernement. Il faut maîtriser les usages, par rôle, par service, par projet.

- Implémenter des règles RBAC (Role-Based Access Control), comme pour un ERP ou un SIRH

- Définir des permissions précises : qui peut poser des questions ? sur quelles données ? à quelle fréquence ?

- Mettre en place un journal d’audit des requêtes (audit trail), pour suivre qui a demandé quoi, quand, et avec quel résultat

📌 Exemple d’erreur évitable :

Un stagiaire en marketing interroge l’IA pour obtenir un comparatif de tarifs fournisseurs… et accède à des marges confidentielles réservées à la direction achats. Cela révèle une absence de filtrage contextuel par rôle.

c. Surveillance, éthique et garde-fous

Même avec du contexte, les LLM peuvent halluciner, interpréter de travers ou produire des réponses biaisées. Il est essentiel d’encadrer leur comportement par des garde-fous (guardrails) et d’anticiper les dérives.

- Filtrer certaines requêtes sensibles (RH, santé, finance…)

- Détecter les hallucinations ou réponses non sourcées

- Imposer un niveau de confiance minimum pour certaines tâches (ex : score de pertinence sur les documents RAG)

- Documenter le fonctionnement de chaque assistant IA : ce qu’il sait, ce qu’il peut faire, ce qu’il ne doit pas faire

📌 Exemple typique d’hallucination :

Un LLM mal configuré rédige une réponse RH mentionnant une règle d’entreprise… qui n’existe pas. L’utilisateur pense que c’est officiel. L’erreur provient d’une confusion avec une autre source juridique.

d. L’IA Act : un cadre réglementaire à anticiper dès maintenant

Le Règlement européen sur l’intelligence artificielle (IA Act), entré en vigueur en 2024, encadre strictement les usages professionnels de l’IA. Il sera progressivement applicable à partir de 2025, avec des obligations fortes pour les systèmes dits “à haut risque”.

Ce que prévoit l’IA Act :

- Catégorisation des usages IA : faible, limité, élevé, interdit

- Documentation obligatoire pour les modèles utilisés : transparence, logique interne, sources

- Supervision humaine obligatoire dans les cas sensibles

- Systèmes de traçabilité et de surveillance continue

- Amendes en cas de non-conformité

📌 Exemple d’usage à haut risque selon l’IA Act : Un assistant IA qui aide à sélectionner des candidats, à noter des collaborateurs, ou à accorder des crédits. Ce type d’outil devra être certifié, documenté, audité, et supervisé par un humain.

5. Activer une vraie approche métier grâce à la mémoire du contexte

Le grand changement avec les LLM modernes, c’est qu’ils peuvent s’adapter dynamiquement à un métier, un utilisateur, une session, un projet à condition d’enrichir leur contexte.

Ce que permet la mémoire du contexte :

- Identifier l’utilisateur, son rôle, son service, ses outils

- Conserver l’historique d’une session ou d’un projet (via MCP)

- Adapter la réponse au vocabulaire et aux objectifs métier (DAF vs RH vs commercial)

Exemples concrets :

🎯 Un directeur commercial échange avec son assistant IA toute la semaine :

- Lundi : demande un rapport sur les leads du mois

- Mercredi : génère une présentation pour son DG

- Vendredi : rédige un plan de relance pour les prospects froids

Grâce à la mémoire contextuelle, l’IA suit le fil de l’histoire sans recommencer de zéro. Elle s’adapte à la stratégie commerciale en cours et offre une continuité logique dans ses propositions.

🎯 Un directeur administratif et financier connecté à son copilote IA pourrait simplement dire :

« Peux-tu m’expliquer pourquoi les frais généraux ont augmenté ce trimestre à Lyon ? »

Grâce au MCP, l’IA sait :

- qui parle (DAF, donc avec des droits étendus),

- dans quel contexte (clôture comptable en cours, périmètre Lyon, Q2 2025),

- quels outils interroger (ERP pour les dépenses, outil de BI pour la ventilation, système de notes de frais),

- quelle action déclencher (analyse des écarts, consolidation des justificatifs, proposition de synthèse).

La réponse générée n’est donc pas générique, mais opérationnelle et contextualisée, par exemple :

« Les frais généraux à Lyon ont augmenté de 18 % au T2, principalement en raison d’une hausse des dépenses événementielles (+40 %) et de frais de sous-traitance temporaire. Voici un graphique comparatif T1 vs T2 et les justificatifs extraits du système. »

✅ Résultat : le DAF gagne un temps considérable, bénéficie d’un assistant proactif qui raisonne avec ses outils, et peut prendre des décisions en confiance.

🤖 Agents IA + MCP, le duo gagnant pour une efficacité maximale

Les agents IA — ces entités autonomes capables d’enchaîner des tâches, de prendre des décisions ou de collaborer avec d’autres outils — trouvent dans le MCP un allié de poids. Le Model Context Protocol sert en effet de "boussole contextuelle" pour ces agents. Il leur permet de :

- Démarrer avec un contexte clair : rôle de l’utilisateur, périmètre métier, historique de la session ou du projet.

- Faire appel aux bons outils grâce à des connecteurs déjà contextualisés.

- Conserver la continuité : un agent peut reprendre une tâche commencée la veille avec toutes les informations utiles déjà en mémoire.

- Collaborer entre eux : plusieurs agents spécialisés (ex : juridique, finance, RH) peuvent dialoguer de manière fluide car ils partagent une même structure contextuelle normalisée via le MCP.

💡 Exemple concret :

Un agent "Assistant de direction" peut planifier une réunion, briefer un autre agent "Analyste financier" sur les documents à préparer, pendant qu’un troisième agent "CRM" met à jour les informations client. Le tout coordonné par un contexte partagé, défini par le MCP.

Le MCP agit ainsi comme une couche d’orchestration du sens, garantissant que chaque agent œuvre dans le bon cadre, avec les bonnes données, pour la bonne personne.

6. Checklist pour connecter un LLM à vos outils métiers en 5 étapes

✅ Cartographier les cas d’usage et sources de données

- Identifiez les cas d’usage prioritaires (ex : support client, RH, DAF, CRM…)

- Listez les outils métier concernés (ERP, CRM, SIRH, GED, etc.)

- Recensez les types de données à intégrer : documents, historiques, bases SQL/NoSQL, fichiers, APIs, etc.

✅ Définir les rôles, accès et périmètres de sécurité

- Implémentez un modèle RBAC (Role-Based Access Control)

- Précisez les autorisations par profil utilisateur

- Activez les journaux d’audit pour tracer les requêtes et garantir la conformité RGPD

✅ Connecter vos données via une mémoire (RAG)

- Choisissez une base vectorielle (Chroma, Weaviate, Pinecone, etc.)

- Préparez et vectorisez les documents métier (conventions, procédures, contrats types…)

- Testez des requêtes avec RAG pour valider la pertinence des réponses générées par le LLM

✅ Mettre en œuvre le Model Context Protocol (MCP)

- Structurez le contexte utilisateur (rôle, projet, objectif, historique…)

- Connectez le LLM aux bons outils via des APIs contextualisées (CRM, ERP, outils internes…)

- Injectez automatiquement les bons éléments de contexte dans chaque requête

✅ Déployer les assistants IA dans votre environnement

- Créez des interfaces ou des agents IA spécialisés par métier

- Intégrez des garde-fous (guardrails) pour éviter les dérives : hallucinations, biais, erreurs réglementaires

- Surveillez, ajustez, mesurez l’impact (temps gagné, qualité des réponses, satisfaction utilisateur)

🛠️ Exemples d'outils possibles

| Besoin | Outils suggérés |

|---|---|

| Base vectorielle | Chroma, Pinecone, Weaviate |

| Orchestration API | n8n (Open source), Zapier, Make.com< |

| LLMs compatibles | Mistral (Open source), OpenAI (via Azure), Claude, Gemini |

| Plateforme intégrée | Synrune (Proovup) pour orchestrer et sécuriser le tout |

En savoir plus : https://synrune.io/

7. Conclusion :

Une IA vraiment utile est une IA connectée, sécurisée et contextualisée

L’ère des chatbots bricolés avec des prompts touche à sa fin. Les LLM, bien que puissants, nécessitent une contextualisation pour devenir de véritables atouts dans votre entreprise. En les connectant à vos données internes, outils et processus, vous transformez une IA générique en un assistant intelligent, capable de comprendre et d'agir selon vos spécificités.

Pour permettre à l'IA de comprendre votre métier, il faut donc transformer la logique “prompt => réponse” en une logique “rôle + contexte + outil + action => réponse pertinente” grâce à :

- Un cadre technique robuste (MCP, RAG, orchestrateurs, agents)

- Une approche centrée sur les besoins, les métiers et la connaissance du contexte de chaque collaborateur

- Une vision stratégique de la data (gouvernance, sécurité, enrichissement)

Les technologies comme le MCP contribuent à faire de l'IA un game changer dans l'entreprise en permettant :

- une intégration fluide dans les outils métiers existants,

- une expérience utilisateur cohérente et continue,

- une réduction drastique des efforts d’intégration et de formation,

- et une automatisation intelligente des tâches, basée sur le contexte réel de travail.

L’IA d’entreprise ne doit pas être une boîte noire qui impressionne et inquiète les collaborateurs. Elle doit devenir un outil clair, pilotable, auditable et aligné avec les objectifs de l'organisation et des équipes.

C’est exactement ce que permet une plateforme intégrée comme Synrune, conçue pour expérimenter puis déployer rapidement des assistants IA sur-mesure, connectés à vos données, aux usages pilotés et centrés sur vos objectifs business.

Quelques sources et références :

- Model Context Protocol (MCP) – https://modelcontextprotocol.io/introduction

- Introduction to MCP – https://www.youtube.com/watch?v=nNLshWCoe0o

- Qu’est-ce que le RAG : https://www.elastic.co/fr/what-is/retrieval-augmented-generation